Cyber- und Manipulationsrisiken

Robotaxis sind vernetzte, softwaregetriebene Systeme und damit potenzielle

Angriffsziele – technisch, physisch und sozial.

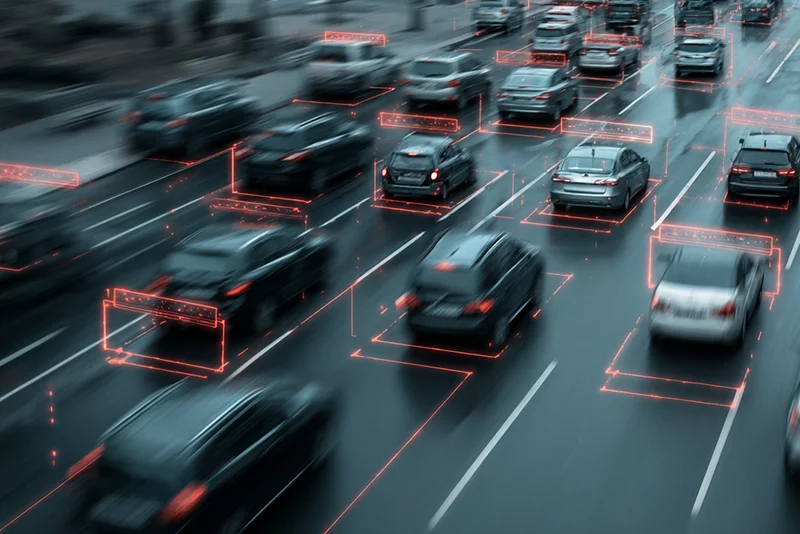

Die Risikolage entsteht nicht isoliert, sondern aus der Kopplung von

Fahrzeug, Software, Backend, Updates und externer Infrastruktur.

Zentrale Angriffsflächen im Robotaxi-Betrieb

Digitale Angriffe

Softwarebasierte Angriffe zielen auf Steuerlogik,

Kommunikationsschnittstellen, OTA-Updates und Backend-Systeme.

- Manipulation von Software-Updates

- Eindringen über API-, Cloud- oder Flottenschnittstellen

- Angriffe auf Kommunikations- und Update-Ketten

Digitale Angriffe wirken skaliert und systemisch – sie betreffen

nicht einzelne Fahrzeuge, sondern ganze Flotten.

Normativer Anker:

ISO/SAE 21434 – Road vehicles — Cybersecurity engineering

Role: Cybersecurity-Lifecycle, Threat Analysis & Risk Assessment (TARA),

Absicherung vernetzter Fahrzeug- und Backend-Systeme

Physische Manipulation

Physische Angriffe greifen direkt an Sensorik, Aktuatoren

oder der Fahrzeugumgebung an.

- Blendung oder Abdeckung von Kameras und LiDAR

- Verfälschung von Markierungen oder Verkehrszeichen

- Eingriffe in Fahrzeughardware oder Wartungsschnittstellen

Solche Eingriffe wirken lokal, können jedoch sicherheitskritische

Fehlentscheidungen auslösen.

Normativer Anker:

ISO 21448 – Safety of the Intended Functionality (SOTIF)

Role: Absicherung von Wahrnehmungs- und Interpretationsgrenzen

ohne klassischen Systemfehler

Soziale & systemische Angriffe

Menschen können autonome Systeme gezielt provozieren,

täuschen oder strategisch ausnutzen.

- Provoziertes Blockieren oder Ausbremsen

- Ausnutzung defensiver Fahrlogik

- Missbrauch von Interaktions- oder Notfallmechanismen

Diese Angriffe zielen nicht auf Technikfehler,

sondern auf vorhersehbares Systemverhalten.

Regulatorischer Anker:

UNECE Regulation No. 155 – Cyber Security & CSMS

Role: Governance, Überwachung und organisatorische Absicherung

gegen Missbrauch und systemische Schwachstellen

Vernetzung, Flottenlogik und externe Infrastruktur erhöhen Reichweite

und Wirkung möglicher Angriffe. Sicherheit entsteht daher nicht allein

durch Technik, sondern durch eine integrierte Kombination aus

Architektur, Governance und kontinuierlicher Überwachung.

Mit wachsender Autonomie wächst die Verantwortung für systemische Resilienz.